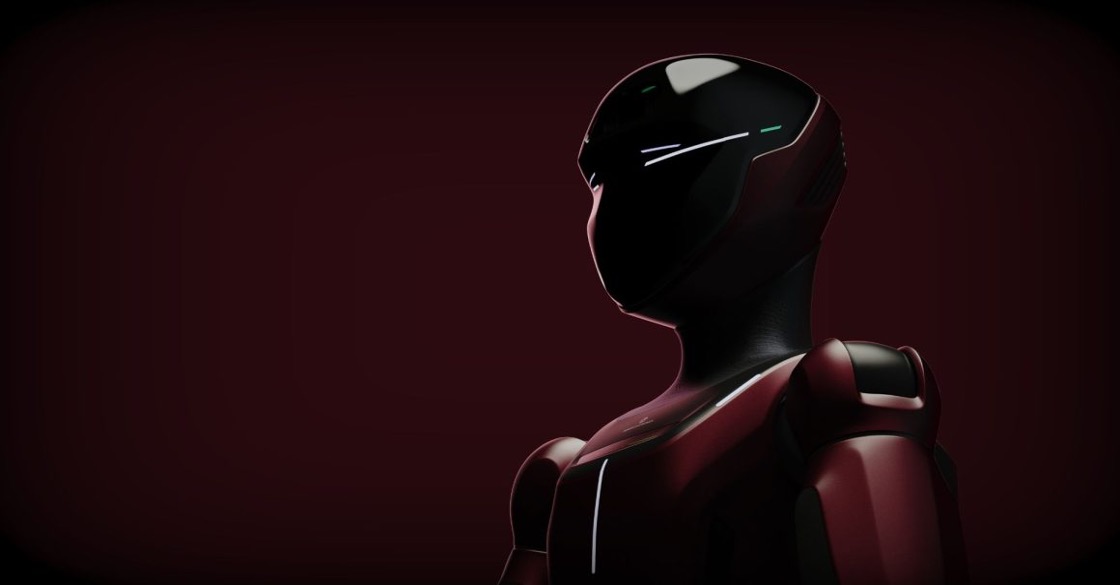

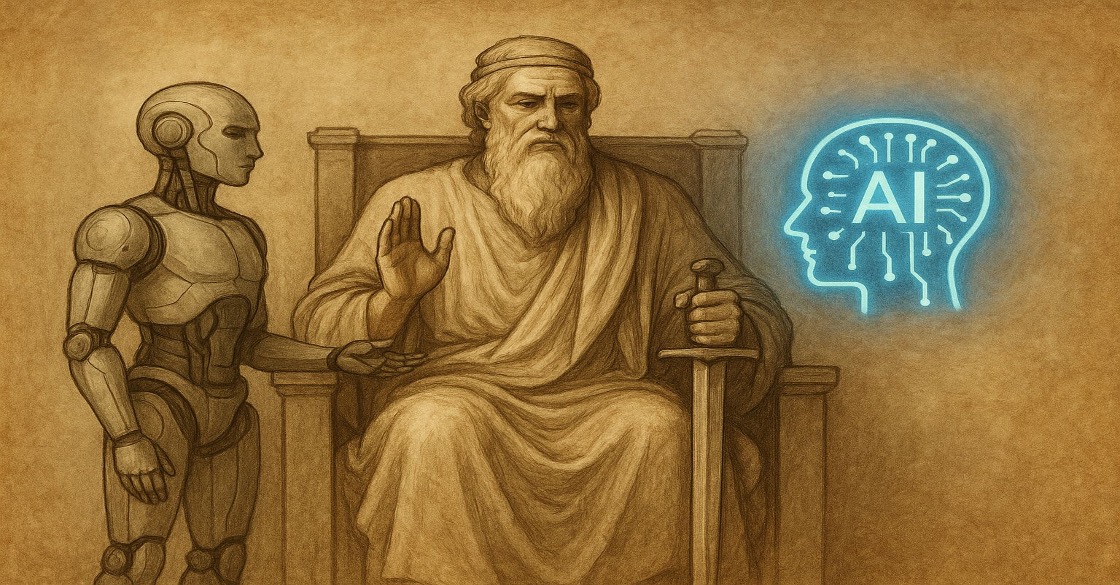

Danni provocati dall’intelligenza artificiale: a chi imputare la responsabilità?

L’Intelligenza Artificiale è sempre più diffusa e utile, ma comporta rischi e responsabilità non ancora chiaramente regolati. L’UE propone norme per gestire i danni causati dall’IA, soprattutto nei sistemi ad alto rischio. Le assicurazioni, già attive nell’uso dell’IA, stanno evolvendo verso modelli predittivi e preventivi. Serve però un equilibrio tra innovazione e tutela giuridica.

L’Intelligenza Artificiale (IA) è un elemento indispensabile ed irrinunciabile nel nostro quotidiano: non è possibile immaginare un’abitazione privata sprovvista di dispositivi interconnessi ovvero di un’azienda che non si serva di strumenti di automazione per svolgere attività in cui l’intervento dell’uomo è sostituibile ovvero di enti pubblici che non si servano dei dati dei cittadini per rielaborarli a fini di pubblica utilità.

Quando si disserta di IA s’intende un sistema basato su un software o integrato in dispositivi hardware che mostra un comportamento atto a simulare l’intelligenza umana, alimentato da dati che vengono raccolti e trattati per analizzare e interpretare il proprio ambiente ovvero per intraprendere azioni con un certo grado di autonomia.

L’IA si presta, dunque, ai campi più disparati e non vi è settore, oggi, che non ne sia toccato: dal settore sanitario a quello finanziario, passando per il mondo assicurativo. L’IA – è innegabile – promette numerosi vantaggi in termini di rapidità, efficienza e precisione. Al contempo, però, il relativo utilizzo comporta potenziali rischi, considerata l’eccessiva pervasività di dati ed algoritmi ed i cc.dd. bias o distorsioni da macchina, ovvero l’effetto di assunzioni ed elaborazioni errate nei processi di apprendimento automatici degli algoritmi. Tali distorsioni derivano da problemi di raccolta o utilizzo dei dati, sulla scorta dei quali i sistemi traggono informazioni errate, per errori plausibilmente connessi all’intervento umano, ma soprattutto – occorre dirlo – per l’assenza di una valutazione consapevoli dei dati stessi.

Quindi, quanto più l’IA evolve offrendo soluzioni a problemi complessi, tanto più essa è suscettibile ad anomalie e malfunzionamenti produttivi di danno.

Gli operatori del diritto si interrogano da tempo sui potenziali profili di responsabilità civile per i danni cagionati dall’IA in generale e, ancor di più, dall’IA generativa. In particolare, ci si interroga se le applicazioni di IA possano essere assimilabili alle condotte di un soggetto dotato di soggettività e capacità giuridica, ovvero imputabile di responsabilità e destinatario di un’eventuale richiesta di risarcimento del danno patito da un terzo danneggiato. Certamente, i sistemi di IA più sofisticati (quali i robot o i sistemi in grado di auto alimentarsi e correggersi in presenza di anomalie, ecc.) hanno motivato coloro che teorizzano la natura di “persona artificiale” del sistema di IA. Lo stesso Parlamento europeo, con risoluzione del 16 febbraio 2017, invitava la Commissione a “creare uno status giuridico specifico per i robot a lungo termine, in modo che almeno i più sofisticati possano essere riconosciuti come persone elettroniche responsabili di riparare eventuali danni che possono causare, ed eventualmente riconoscerlo ai casi in cui prendono decisioni autonome o interagiscono con terze parti in modo indipendente”.

Invero, è innegabile il silenzio dei Legislatori, europeo e nazionali, sul punto ed è altrettanto vero che vi sia riluttanza da parte degli ordinamenti a sostenere la natura “umanoide” dei sistemi di IA – ancorché sofisticati – per riferirsi, invece, ad una generica responsabilità da prodotto.

Indipendentemente dall’orientamento, i sistemi di IA sono imperfetti “per definizione” e richiedono aggiornamenti costanti al fine di correggerne gli errori. Laddove vi siano anomalie, dunque, sorge un possibile danno in capo al soggetto che ne patisce i relativi gli effetti.

In questo senso è intervenuta l’Unione Europea che, con la Proposta di regolamento del Parlamento europeo e del Consiglio, che stabilisce regole armonizzate sull’IA e modifica alcuni atti dell’Unione del 21 aprile 2021 e la Proposta di Direttiva del Parlamento europeo e del Consiglio, relativa all’adeguamento delle norme in materia di responsabilità civile extracontrattuale all’IA del 28 settembre 2022, ha inteso “inquadrare” il complesso quadro di responsabilità scaturenti da errori e anomalie dei sistemi di IA e degli eventuali profili di danno ad essi ascrivibili.

In particolare, i danni presi in considerazioni dalle norme in parola – specie nei sistemi di IA più sofisticati – sarebbero di diversa entità e possono andare dalla lesione di diritti della persona costituzionalmente garantiti, al pregiudizio lieve o momentaneo, ma non per questo meno meritevole di tutela (i.e. copertura assicurativa per quello che interessa).

In tale scenario l’industria assicurativa, già avvezza all’utilizzo di strumenti di IA grazie all’evoluzione dell’Insurtech, si sta determinando – e sensibilizzando – rispetto ad un cambiamento nell’approccio, non solo nei confronti del cliente, ma anche e soprattutto nella gestione sinistro, che grazie all’utilizzo degli algoritmi diventa sempre più puntuale ed oculata (e l’intervento umano ridotto al minimo). L’atteggiamento che pian piano si fa strada è, dunque, quello maggiormente preventivo, in luogo di quello riparativo sinora utilizzato. Lo stesso concetto di rischio sta mutando, diventando sempre più specifico e predittivo. La previsione vede farsi spazio ad una sorta di customizzazione delle polizze, ben immaginabile nelle cd. micro-assicurazioni, ossia in relazione a quei contratti assicurativi brevi, semplificati e magari attivabili in pochi secondi, interessati a tutelare appunto esigenze momentanee del cliente (ad es. inconveniente o imprevisti durante un viaggio).

Tornando al focus del presente articolo, di nodale importanza sono i seguenti quesiti: quale sia il tipo di responsabilità invocabile e su chi sorga il dovere di risarcire il danno eventualmente cagionato dal sistema di IA (sia esso incorporato o meno ad una macchina), posto che le normative nazionali sono per lo più lacunose o farraginose e che, a livello europeo, manca una disciplina specifica in materia.

Che, da una parte, la scelta di non normare eccessivamente sia dettata dalla necessità di non ostacolare la corsa all’innovazione, appare di tutta evidenza. D’altra parte, però, è necessario prevedere adeguati strumenti di tutela nei casi di danni cagionati da sistemi di IA considerati ad “alto rischio”. La Proposta di regolamento sopra citata ha, in effetti, operato una distinzione: i sistemi di IA vietati, i sistemi di IA ad alto rischio, sottoposti a regolamentazione, ed i sistemi di IA a rischio limitato, sottoposti a regolamentazione minimale.

Tutti i sistemi IA non appartenenti alle categorie specificate, non sono soggetti a regolamentazione specifica.

Con la Proposta di direttiva, invece, la Commissione ha inteso prevedere un sistema di presunzioni per assicurare ai danneggiati un equo risarcimento, introducendo il requisito della colpa, intesa come carente organizzazione aziendale del fornitore o dell’utente.

In tal senso, la Proposta di Direttiva sembra cogliere l’aspetto critico centrale, consistente nel fatto che il sistema di IA si interpone tra il comportamento del soggetto ed il danno, recando un elemento di opacità nella relazione causale.

Affinché si possa applicare la presunzione di causalità, la condotta del danneggiante deve consistere in un comportamento umano attivo od omissivo non conforme all’obbligo di diligenza richiesto dal diritto UE e nazionale direttamente inteso a proteggere la persona. Es. utente non si attiene alle istruzioni d’uso.

La colpa è sia generica (disallineamento del comportamento ad un livello di diligenza che si può pretendere dall’agente), sia specifica (violazione di specifici precetti normativi) e, in Italia, le regole cui fare riferimento per gli operatori del diritto sono quelle dell’art. 2043 c.c., secondo cui, per la prova del nesso causale, è necessario che alla colpa dell’agente vada ricondotto l’evento causalmente ascrivibile alla condotta violativa della regola cautelare.

Quanto sopra è senz’altro un passo avanti rispetto al passato, tuttavia, le fonti sopra citate sono ancora allo stadio di proposte e non sembrano risolvere il problema con riferimento alla difficoltà di prova laddove oggetto del contendere siano sistemi le cui conoscenze non sarebbero ad appannaggio dell’utente ovvero che potrebbero costituire segreto industriale, a sua volta suscettibile di protezione.

Un ulteriore elemento di riflessione, come accennato, è costituito dalla circostanza che l’eccessiva normativizzazione costituisca un ostacolo all’innovazione ed alla rapida crescita.

Un caso concreto riguarda, ad esempio, le vetture a guida autonoma che, ad oggi, risultano soggette al Regolamento sulle omologazioni e prevedono che i sistemi di IA, integrati ai veicoli, siano posti sotto il controllo del produttore, del fornitore di servizi, dell’utente ed infine dell’utilizzatore.

Ci si chiede, quindi, che cosa possa succedere nel caso in cui veicoli più sofisticati (che superino il livello 2 attualmente previsto dalla normativa vigente, raggiungendo i livelli 3 o 4) inizino a circolare sulle strade ma la normativa in essere sia troppo vecchia o non preveda adeguati strumenti di tutela?

Certamente, l’attesa di una reazione del Legislatore ovvero la necessità di irrigidire in schemi normativi un settore – come quello dell’IA – in costante evoluzione e crescita provocherebbero un rallentamento della ricerca e della tecnica. Questa impasse si rivelerebbe dannosa per il tessuto imprenditoriale europeo e gli effetti, ad oggi, sembrano già essere tangibili: la Cina, infatti, ha annunciato, solo qualche giorno fa, la “Robocar 01 JiYue”, la prima auto elettrica con guida autonoma di livello 4 in grado di percorrere autonomamente il 90% delle autostrade cinesi e circolare all’interno di Hangzhou, Pechino e Shanghai e, nel 2024, in altre 200 città cinesi. In Europa, il livello di guida autonoma ammesso è il 2. Probabilmente, una soluzione per superare l’ostacolo all’innovazione garantendo, al contempo, una disciplina normativa adeguata ed orientata alla tutela contro i danni cagionati dai sistemi di IA potrebbe essere, come suggerito dagli artt. 60 e 62 della Proposta di Regolamento, di prevedere che i sistemi di IA possano continuare ad auto apprendere (anche ove il destinatario sia un consumatore) e che il fornitore registri ogni incidente derivante dal malfunzionamento di un sistema di IA.

Sul fronte delle Compagnie di assicurazioni (anch’esse non esenti dall’implementazione di sistemi di IA sempre più sofisticati), minore sarà il rischio di bias della macchina, minori saranno – auspicabilmente – le probabilità del verificarsi di danni e quindi di sinistri, per la cui copertura l’assicuratore dovrà preoccuparsi di attivarsi in ottica riparativa, ben potendo concentrarsi, al contrario, sulla distribuzione di prodotti assicurativi di natura, appunto, predittiva e preventiva.

Ad ogni modo, quel che è certo oggi è che un approccio etico, responsabile e sostenibile delle tecnologie IA, in aggiunta a quanto sopra rilevato, è quanto mai urgente e necessario.

Questo articolo è stato redatto insieme a Flavia Bartolazzi.

Scarica qui l’articolo completo in PDF.